En Blockchain, der virkelig kan skaleres

I næsten 20 år udviklede CPU’er sig i en utrolig hastighed. I henhold til Moores lov fordoblede CPU’er hastigheden omtrent hver 18. måned indtil midten af 2000’erne, da virksomheder begyndte at udforske nyt multi-core design. Til sidst ville processorer blive quad core, derefter hex-core, derefter octo-core og mere, da teknologivirksomheder begyndte at søge efter måder til at designe de hurtigste og mest effektive maskiner.

Tilføjelse af yderligere kerner til CPU’en betyder ikke nødvendigvis, at computeren var hurtigere, men derimod tillod flere programmer at køre på én gang. Da man troede, at grænserne for behandling med en enkelt kerne var nået, udtænkte ingeniører smarte måder til fortsat at øge computerens magt og kapacitet.

Det tætteste ved en blockchainækvivalent til en CPU ville være en node. En node er en elektronisk enhed, der er forbundet til en blockchains netværk og gemmer en kopi af denne blockchain. Noder tager sig af 3 aspekter af en blockchain.

For det første har de ansvaret for beregningskomponenten. Dette er den komponent, som de fleste mennesker vil forstå som hashing af transaktionerne og oprettelse af blokke. Det andet element er lagring af resultaterne i hovedbogen, og den tredje komponent er konsensus, det vil sige at kontrollere, at dataene er korrekte. Det første og tredje element er generelt afhængige af beregningskraften for hver node og den hastighed, hver transaktion kan behandles. Lagringen er afhængig af et lidt andet aspekt af en nodes ydeevne.

Den aktuelle nodeopsætning er, hvor en node består af en computer, i det væsentlige en enkeltkerne-CPU. Problemet med dette er, at for at forbedre netværksydelsen skal du forbedre ydeevnen for hver enkelt node.

Forbedring er absolut nødvendig.

Vi fortsætter med at se tilfælde, hvor blockchains bliver overbelastede; de sænker eller bliver for dyre til at blive brugt. Dette relaterer direkte til nodernes ydeevne. Ingeniører har måttet være mere intuitive med deres løsninger, og det bør ikke være en overraskelse, at der har været en lang række måder, som blockchain-udviklere har forsøgt at forbedre denne teknologi.

Almindelige løsninger har været at forsøge at øge blokstørrelsen (øge hastigheden, som information kan behandles, men dette øger også den hastighed, hvormed blockchain vokser), skriver enklere smarte kontrakter, eller forbedring af konsensusmekanisme for at gøre netværket mindre afhængigt af alle noder (som ofte kommer med bivirkningen ved at miste en vis decentralisering).

Men ingen af disse løsninger adresserer problemet i hjertet af blockchain-skalerbarhedsproblemet – at da en blockchain bliver mere populær og vellykket, vil der uundgåeligt blive et stort efterslæb af transaktioner, der skal verificeres med hver på hinanden følgende blok, og blockchain vil til sidst bremse op.

Dette er yderligere frustreret, når smarte kontraktplatforme f.eks Ethereum, har brug for at køre ikke-konkurrerende smarte kontrakter sekventielt og tager tid og processorkraft.

Man kunne teoretisk tilføje mere ydelse til den ene computer, men dette bliver hurtigt ude af proportioner for forholdet mellem omkostninger og fordele. Læg dette til side, så når man den fysiske grænse for den udviklede teknologi.

Men selv før vi når dette punkt, er der 2 flere begrænsende faktorer, der spiller ind. Først ved at køre 1 transaktion ad gangen vil der klart være begrænsende faktorer, idet hver transaktion skal behandles, vil tage tid, og denne minimumstid kan ikke reduceres yderligere. Men på et andet niveau har vi den fysiske skrivehastighedsgrænse for datalagring. Du kan ikke fysisk skrive data hurtigere end den harddisk, som den er gemt på.

En tilgang, der hidtil har undgået udviklere, er konceptet med at tilføje mere end en computer til en individuel node. På samme måde som en CPU, der nu kører flere kerner samtidigt, selv har tacklet denne tilgang frontalt.

Problemet med dette ligger i kun to ord: transaktionsafhængighed. Jeg går nærmere ind på dette i min artikel om parallel behandling. Men i det væsentlige, når transaktionsafhængighed er løst, kan man begynde at tilføje flere computere til den ene node.

Ved at oprette noder, der består af flere computere, der kan køre parallelt, er selv i stand til at behandle ikke-konkurrerende transaktioner på samme tid. Ligesom flere kerner i en processor tillader en computer at køre flere programmer på én gang, tillader flere computere i en node en blockchain at kontrollere flere transaktioner på én gang.

Dette betyder også, at knudepunkterne er skalerbare – det naturlige problem med blockchains tidligere mangel på knudepunktets skalerbarhed. Computere kan tilføjes eller trækkes fra noder, hvilket betyder, at hvis transaktionerne vokser mere komplekse, eller der er andre ændringer i blockchain, kan noderne tilpasse sig til at imødekomme de nye krav fra blockchain.

Denne fleksibilitet er afgørende for ethvert projekt, der planlægger at vare langt ind i fremtiden.

Dette har rettet den beregningskomponente blokchainhastighed, men vi har stadig problemet med datalagringshastigheder. aelf er også kommet med en innovativ tilgang. Det vil sige at opdele datalagringsprocessen fra den beregningsmæssige behandlingskomponent.

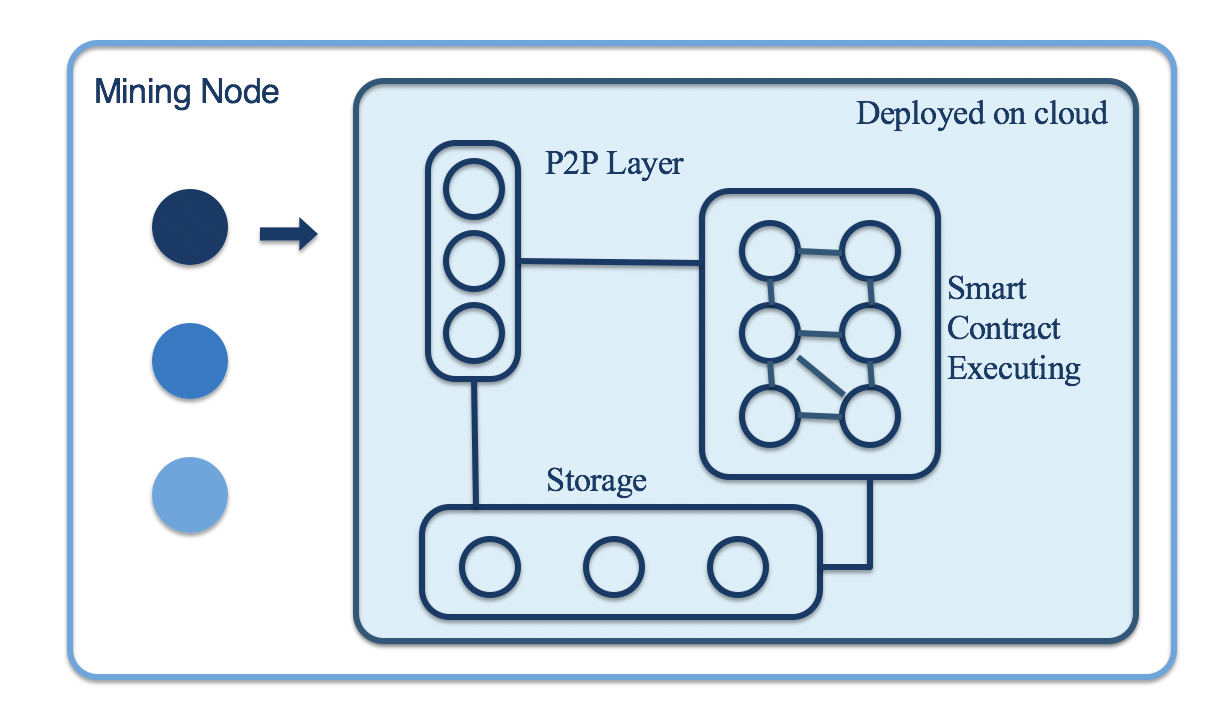

For at forklare dette i enkle vendinger kan du sige, at en aelf-node vil blive opdelt i 2 klynger. En klynge af computere vil fokusere på beregningsprocesserne, mens den anden klynge vil fokusere på datalagringskomponenten. Dette har nu fjernet de fysiske begrænsende faktorer for begge lag.

Som standard gemmes blockchain-hovedbogen nu på en klynge af computere snarere end på hver enkelt computer. Teknisk set vil der stadig eksistere en komplet hovedbog på hver knude.

Ved at have denne tilgang skal aelf simpelthen tilføje en anden computer til en node for at forbedre blockchainens skalerbarhed. Mange projekter taler om, at deres blockchain er skalerbar, men ingen har løst disse kerneproblemer på en sådan måde, som fremtiden beviser det fra flaskehalse.

aelf implementerer en løsning, der er levedygtig for nuværende og fremtidige behov adoption af blockchain. De har også designet økosystemet på en sådan måde, at det kan udvikle sig efter fremtidige behov. Dette gør det muligt for elementer som Consensus Protocol at tilpasse sig, hvis en nyere protokol udvikles med højere sikkerhed, eller hvis en sidekædes krav ændres.

Aelf har netop meddelt, at de ved at bruge denne tilgang var i stand til at oprette et stabilt testnet V1.0, som havde en TPS på 15.000.

For at dette skal være basen, som aelf bygger videre med en sådan skalerbar blockchain, er det ikke underligt, at sådanne tunge hitters i branchen har støttet dem og tilsluttet sig selv som partnere. Dette inkluderer Huobi, Michael Arrington, og FBG Capital bare for at nævne nogle få.

Aelf er helt sikkert en af blokkæderne, der skal overvåges i løbet af de næste 12 måneder, da de fortsætter med at annoncere nye partnerskaber hvert par uger og lancere deres mainnet i 1. kvartal 2019.

Hvis du gerne vil læse mere om mig selv eller om mig om generelle kryptovaluta-nyheder, bedes du besøg min blog.

Relateret: Race for Cross-Chain Communication: 11 projekter, der arbejder på Blockchain-interoperabilitet